Wie visionsgesteuerte IRB-Manipulatoren das robotergestützte Behälter-Picking verwandeln—Präzision, Geschwindigkeit und Intelligenz neu definiert. Entdecken Sie die nächste Generation der automatisierten Materialhandhabung.

- Einführung in das robotergestützte Behälter-Picking und IRB-Manipulatoren

- Die Rolle von Sichtsystemen beim modernen Behälter-Picking

- Schlüsseltechnologien hinter visionsgesteuerten IRB-Manipulatoren

- Workflow: Von der Objekterkennung zur Greifausführung

- Herausforderungen beim Behälter-Picking: Okklusion, Unordnung und Variabilität

- Fallstudien: Einsätze in der realen Welt und Leistungskennzahlen

- Integration mit bestehenden Automatisierungssystemen

- Zukünftige Trends: KI, Deep Learning und adaptive Robotik

- Fazit: Die Auswirkungen und Aussichten für das visionsgesteuerte Behälter-Picking

- Quellen & Referenzen

Einführung in das robotergestützte Behälter-Picking und IRB-Manipulatoren

Robotergestütztes Behälter-Picking ist eine transformative Technologie in der industriellen Automatisierung, die es Robotern ermöglicht, Objekte aus ungeordneten Behältern oder Containern zu identifizieren, auszuwählen und abzurufen. Dieser Prozess ist besonders herausfordernd aufgrund der zufälligen Ausrichtung, Überlappungen und Vielfalt der Teile, die typischerweise in solchen Umgebungen vorhanden sind. Die Integration von visionsgesteuerten Systemen mit industriellen Roboterarmen, wie den IRB-Serie-Manipulatoren von ABB, hat die Fähigkeiten der Behälter-Picking-Lösungen erheblich verbessert. Vision-gesteuerte IRB-Manipulatoren nutzen raffinierte 2D- und 3D-Bildgebungstechnologien, um die Umgebung wahrzunehmen, Objekte zu lokalisieren und kollisionsfreie Trajektorien für das Picking zu planen, selbst in unordentlichen oder dynamischen Umgebungen.

Die IRB-Familie von Robotern, entwickelt von ABB, ist bekannt für ihre Präzision, Flexibilität und Zuverlässigkeit in anspruchsvollen industriellen Anwendungen. Ausgestattet mit fortschrittlichen Sichtsystemen können diese Manipulatoren autonom eine Vielzahl von Teilen handhaben, von kleinen mechanischen Komponenten bis hin zu größeren, unregelmäßig geformten Gegenständen. Die Synergie zwischen Sichtalgorithmen und roboterbasiertem Steuerungsbewusstsein ermöglicht eine Echtzeit-Entscheidungsfindung, die es dem System erlaubt, sich an Variationen in der Teileposition, Ausrichtung und den Bedingungen im Behälter anzupassen. Diese Fähigkeit erhöht nicht nur den Durchsatz und reduziert die manuelle Arbeit, sondern minimiert auch Fehler und Schäden an Teilen.

Jüngste Fortschritte in den Bereichen maschinelles Lernen, Sensorsch fusion und Echtzeit-Datenverarbeitung haben die Leistung von vision-gesteuerten Behälter-Picking-Systemen weiter verbessert. Infolgedessen übernehmen Branchen wie die Automobil-, Elektronik- und Logistikbranche zunehmend diese Lösungen, um Abläufe zu rationalisieren und die Produktivität zu steigern. Die kontinuierliche Entwicklung des robotergestützten Behälter-Pickings mit vision-gesteuerten IRB-Manipulatoren schiebt weiterhin die Grenzen der Automatisierung, und setzt neue Maßstäbe für Effizienz und Flexibilität in modernen Fertigungsumgebungen.

Die Rolle von Sichtsystemen beim modernen Behälter-Picking

Sichtsysteme sind ein Eckpfeiler für die Weiterentwicklung der Fähigkeiten des robotergestützten Behälter-Pickings, insbesondere wenn sie mit IRB (Industrieroboter-) Manipulatoren integriert werden. Im Gegensatz zur traditionellen Automatisierung, die auf vorprogrammierten Wegen und festen Objektpositionen beruht, ermöglichen vision-gesteuerte Systeme Robotern, ihre Umgebung dynamisch wahrzunehmen und zu interpretieren. Diese Anpassungsfähigkeit ist entscheidend für den Umgang mit der inhärenten Zufälligkeit und Unordnung, die in industriellen Behältern zu finden ist, wo Teile übereinandergestapelt, überlappt oder unvorhersehbar ausgerichtet sein können.

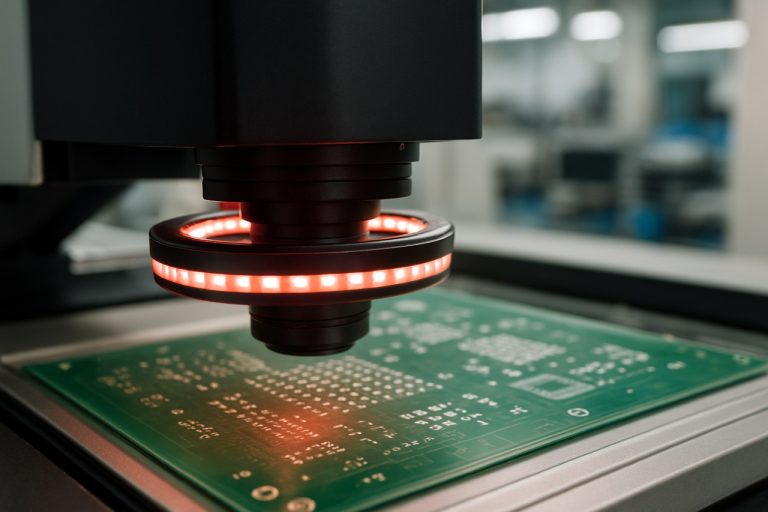

Moderne Sichtsysteme verwenden typischerweise 2D- oder 3D-Kameras, die häufig mit strukturiertem Licht oder Zeit-of-Flight-Sensoren erweitert werden, um detaillierte räumliche Daten über den Inhalt des Behälters zu generieren. Fortgeschrittene Bildverarbeitungs- und maschinelle Lernalgorithmen analysieren dann diese Daten, um einzelne Objekte zu identifizieren, zu lokalisieren und die optimalen Greifpunkte für jedes Objekt zu bestimmen. Dieser Prozess ermöglicht es IRB-Manipulatoren, präzise Pick-and-Place-Operationen auszuführen, selbst in komplexen Szenarien mit reflektierenden, transparenten oder verformbaren Elementen.

Die Integration von Sichtsystemen mit IRB-Manipulatoren erhöht nicht nur die Genauigkeit und Geschwindigkeit des Pickings, sondern reduziert auch den Bedarf an maßgeschneiderten Vorrichtungen und manueller Intervention. Diese Flexibilität ist insbesondere in Branchen wie Automobil, Elektronik und Logistik von unschätzbarem Wert, wo die Produktvielfalt und die Umrüstzeiten hoch sind. Führende Automatisierungsanbieter wie ABB haben anspruchsvolle vision-gesteuerte Lösungen entwickelt, die nahtlos mit ihren IRB-Roboterfamilien interagieren und eine schnelle Implementierung und Skalierbarkeit in vielfältigen Fertigungsumgebungen ermöglichen.

Da sich die Sichttechnologie weiterentwickelt, mit Verbesserungen in der Sensorauflösung, der Verarbeitungs Geschwindigkeit und der KI-gesteuerten Erkennung, wird erwartet, dass die Rolle der Sichtsysteme beim robotergestützten Behälter-Picking weiter zunimmt, was zu größerer Effizienz und Autonomie in der industriellen Automatisierung führt.

Schlüsseltechnologien hinter visionsgesteuerten IRB-Manipulatoren

Vision-gesteuerte IRB (Industrieroboter-) Manipulatoren haben das robotergestützte Behälter-Picking revolutioniert, indem sie fortschrittliche Sensor-, Wahrnehmungs- und Steuerungstechnologien integriert haben. Im Kern dieser Systeme stehen hochauflösende 2D- und 3D-Visionssensoren, wie strukturierte Lichtkameras, Stereo-Vision und Zeit-of-Flight-Sensoren, die eine genaue Erkennung und Lokalisierung von zufällig ausgerichteten Objekten in Behältern ermöglichen. Diese Sensoren erzeugen detaillierte Punktwolken oder Bilder, die dann mit Hilfe raffinierter Computer-Vision-Algorithmen verarbeitet werden, um einzelne Elemente zu segmentieren und ihre Posen zu schätzen, selbst in unordentlichen oder teilweise okkludierten Umgebungen (ABB Vision Systeme).

Maschinelles Lernen, insbesondere Deep Learning, spielt eine entscheidende Rolle bei der Verbesserung der Objekterkennung und Pose-Schätzung. Neuronale Netzwerke, die auf großen Datensätzen trainiert werden, können eine Vielzahl von Objekten robust identifizieren und sich mit minimalem Nachtraining an neue Artikel anpassen. Diese Anpassungsfähigkeit ist für flexible Fertigungs- und Logistikanwendungen von wesentlicher Bedeutung, in denen sich Produkttypen und Verpackungen häufig ändern (NVIDIA Robotics).

Sobald Objekte identifiziert und lokalisiert sind, berechnen fortgeschrittene Bewegungsplanungsalgorithmen kollisionsfreie Trajektorien für den IRB-Manipulator. Diese Algorithmen müssen die Kinematik des Roboters, die Geometrie des Behälters und die dynamische Umgebung berücksichtigen, um sicheres und effizientes Picking zu gewährleisten. Echtzeit-Feedback von Kraft-Drehmoment-Sensoren und Sichtsystemen ermöglicht eine geschlossene Regelung, die es dem Manipulator erlaubt, seinen Griff und seinen Pfad als Reaktion auf unerwartete Änderungen oder Fehler anzupassen (KUKA Robot Vision).

Zusammen ermöglichen diese Technologien, dass vision-gesteuerte IRB-Manipulatoren hohe Genauigkeit, Geschwindigkeit und Zuverlässigkeit bei robotergestützten Behälter-Picking-Aufgaben erreichen, und unterstützen die Anforderungen moderner automatisierter Produktions- und Verteilungssysteme.

Workflow: Von der Objekterkennung zur Greifausführung

Der Workflow für das robotergestützte Behälter-Picking mit vision-gesteuerten IRB-Manipulatoren ist ein mehrstufiger Prozess, der fortschrittliche Wahrnehmung, Planung und Betätigung integriert. Die Sequenz beginnt mit der Objekterkennung, bei der 2D- oder 3D-Vision-Systeme—häufig basierend auf strukturiertem Licht, Stereo-Kameras oder Zeit-of-Flight-Sensoren—die Szene im Behälter erfassen. Raffinierte Algorithmen, die häufig auf Deep Learning zurückgreifen, segmentieren und identifizieren einzelne Objekte, selbst in unordentlichen oder teilweise okkludierten Umgebungen. Dieser Schritt ist entscheidend für eine präzise Lokalisierung und wird durch eine robuste Kalibrierung zwischen dem Sicht system und dem Koordinatensystem des IRB-Manipulators unterstützt (ABB Robotik).

Sobald Objekte erkannt sind, bestimmen Pose-Schätzungsalgorithmen die genaue 6D-Position und Orientierung jedes Elements. Diese Informationen fließen in Greifplanungsmodule ein, die realisierbare Greifpunkte basierend auf der Geometrie des Objekts, den Materialeigenschaften und den kinematischen Einschränkungen des Manipulators bewerten. Moderne Systeme verwenden häufig maschinelles Lernen oder simulationsbasierte Ansätze, um die Greifauswahl hinsichtlich Zuverlässigkeit und Effizienz zu optimieren (Festo).

Die letzte Phase ist die Greifausführung. Der IRB-Manipulator plant, geleitet durch das Echtzeit-Feedback des Sichtsystems, eine kollisionsfreie Trajektorie zum ausgewählten Objekt. Fortgeschrittene Bewegungsplanung stellt reibungslose, sichere Bewegungen sicher, selbst in dynamischen oder unvorhersehbaren Behälterumgebungen. Geschlossene Regelungen, die manchmal durch taktische oder Kraftsensoren unterstützt werden, ermöglichen es dem Roboter, sich an kleine Abweichungen während des Greifens und Hebens anzupassen, um hohe Erfolgsquoten in industriellen Anwendungen sicherzustellen (KUKA).

Herausforderungen beim Behälter-Picking: Okklusion, Unordnung und Variabilität

Das robotergestützte Behälter-Picking mit vision-gesteuerten IRB (Industrieroboter-) Manipulatoren steht vor erheblichen Herausforderungen aufgrund der inhärenten Komplexität unstrukturierter Umgebungen. Ein primäres Hindernis ist die Okklusion, bei der Objekte in einem Behälter sich gegenseitig blockieren, sodass es für die Sichtsysteme schwierig ist, einzelne Elemente genau zu erkennen und zu lokalisieren. Dieses Problem wird verschärft, wenn Objekte übereinandergestapelt oder zufällig ausgerichtet sind, was zu teilweiser oder vollständiger Unauffindbarkeit einiger Gegenstände aus bestimmten Blickwinkeln führt. Fortgeschrittene 3D-Vision-Algorithmen und Mehrsichtbilder werden entwickelt, um Okklusionen zu mildern, doch die Echtzeit-Performance und Zuverlässigkeit bleiben fortlaufende Herausforderungen (ABB Robotik).

Eine weitere größere Herausforderung ist Unordnung. Behälter enthalten oft eine dichte Mischung von Objekten, die die Segmentierungsalgorithmen verwirren und die Wahrscheinlichkeit von Kollisionen oder fehlgeschlagenen Greifvorgängen erhöhen können. Unordentliche Szenen erfordern robuste Wahrnehmungssysteme, die in der Lage sind, die Objektgrenzen zu unterscheiden und realisierbare Greifpunkte zu identifizieren, selbst wenn sich Elemente nahe beieinander oder teilweise überlappen. Die Komplexität unordentlicher Umgebungen erfordert oft die Integration von maschinellen Lern Techniken zur Verbesserung der Objekterkennung und Manipulationsstrategien (Fraunhofer-Gesellschaft).

Schließlich erschwert Variabilität in Form, Größe, Material und Oberflächenreflexion die Behälter-Picking-Aufgaben weiter. Vision-gesteuerte IRB-Manipulatoren müssen sich an ein breites Spektrum von Gegenständen anpassen, von transparenten Kunststoffen bis hin zu glänzenden Metallen, die jeweils einzigartige Wahrnehmungs- und Handhabung Herausforderungen darstellen. Diese Variabilität erfordert flexible Sichtalgorithmen und adaptive Greifplanung, um einen zuverlässigen Betrieb über verschiedene Produktlinien hinweg zu gewährleisten (KUKA AG).

Fallstudien: Einsätze in der realen Welt und Leistungskennzahlen

Einsätze von robotergestützten Behälter-Picking-Systemen, die vision-gesteuerte IRB (Industrieroboter-) Manipulatoren nutzen, haben bedeutende Fortschritte in der Automatisierung gezeigt, insbesondere in den Bereichen Logistik, Fertigung und Lagerhaltung. Beispielsweise hat ABB vision-gesteuerte IRB-Roboter in Automobil- und Elektronikmontagelinien implementiert, wo die Roboter autonom zufällig ausgerichtete Teile aus Behältern identifizieren, lokalisieren und abrufen. Diese Systeme nutzen fortschrittliche 3D-Vision-Sensoren und KI-gesteuerte Algorithmen, um mit komplexen, unordentlichen Umgebungen umzugehen und Picking-Raten zu erreichen, die mit manueller Arbeit konkurrieren oder diese sogar übertreffen können.

Leistungskennzahlen aus diesen Einsätzen konzentrieren sich typischerweise auf die Picker-Genauigkeit, die Zykluszeit, die Systemverfügbarkeit und die Anpassungsfähigkeit an Teilevariationen. In einem bemerkenswerten Fall berichtete FANUC America, dass ihre vision-gesteuerten Behälter-Picking-Lösungen Picking-Genauigkeiten von über 99 % und Zykluszeiten von nur 3-5 Sekunden pro Pick erreicht haben, selbst mit gemischten Teilbehältern. Darüber hinaus hat die Integration von Deep-Learning-gestützten Sichtsystemen es den Robotern ermöglicht, sich mit minimaler Neuprogrammierung an neue Teile anzupassen, die Ausfallzeiten zu reduzieren und die betriebliche Flexibilität zu erhöhen.

Ein weiterer wichtiger Leistungskennwert ist die Robustheit des Systems im Umgang mit Okklusionen und überlappenden Objekten. Einsätze von KUKA haben gezeigt, dass die Kombination von hochauflösenden 3D-Kameras mit IRB-Manipulatoren die Fehlpick- und Kollisionsraten erheblich senken kann, selbst in dicht gepackten Behältern. Diese Fallstudien aus der realen Welt unterstreichen die Maturität und Zuverlässigkeit des vision-gesteuerten IRB-Behälter-Pickings und heben seine wachsend Rolle bei der Erreichung von vollständig automatisierten, hochdurchsatz Materialhandhabungsoperationen hervor.

Integration mit bestehenden Automatisierungssystemen

Die Integration vision-gesteuerter IRB-Manipulatoren für das robotergestützte Behälter-Picking in bestehende Automatisierungssysteme bietet sowohl Chancen als auch Herausforderungen. Eine nahtlose Integration erfordert eine sorgfältige Berücksichtigung von Kommunikationsprotokollen, Datenaustauschformaten und der Synchronisation mit vorgelagerten und nachgelagerten Prozessen. Moderne IRB-Roboter, wie die von ABB Robotics, sind mit offenen Schnittstellen wie OPC UA, Ethernet/IP und PROFINET ausgestattet, die eine unkomplizierte Anbindung an speicherprogrammierbare Steuerungen (SPS), Fertigungsleitsysteme (MES) und Supervisory Control and Data Acquisition (SCADA)-Plattformen ermöglichen.

Ein wichtiger Aspekt ist die Harmonisierung der Ausgaben des Sichtsystems mit der Bewegungsplanungs- und Steuerungssoftware des Roboters. Das vision-gesteuerte Behälter-Picking erfordert Echtzeit-3D-Daten, die häufig von strukturiertem Licht oder Stereo-Kameras bereitgestellt werden, die verarbeitet und in umsetzbare Roboterausgaben übersetzt werden müssen. Dies erfordert robuste Middleware oder Integrationssoftware wie ROS-Industrial, die die Kluft zwischen Sichtalgorithmen und industriellen Robotersteuerungen überbrückt.

Darüber hinaus müssen Sicherheits- und Fehlerbehandlungsprotokolle mit den bestehenden Anlagenstandards in Einklang gebracht werden. Beispielsweise sorgt die Integration von sicherheitsüberwachten Stopp- und Not-Aus-Schaltungen dafür, dass die Hinzufügung des robotergestützten Behälter-Pickings die Gesamtsystem sicherheit nicht gefährdet. Letztlich beinhaltet eine erfolgreiche Integration oft Simulationen und digitale Zwillings technologie, die es Ingenieuren ermöglichen, Arbeitsabläufe zu validieren und Zykluszeiten vor der Implementierung zu optimieren, unterstützt von Plattformen wie ABB RobotStudio. Dieser ganzheitliche Ansatz stellt sicher, dass vision-gesteuerte IRB-Manipulatoren die Produktivität steigern und gleichzeitig die Kompatibilität und Zuverlässigkeit in etablierten Automatisierungsumgebungen wahren.

Zukünftige Trends: KI, Deep Learning und adaptive Robotik

Die Zukunft des robotergestützten Behälter-Pickings mit vision-gesteuerten IRB (Industrieroboter-) Manipulatoren wird durch schnelle Fortschritte in den Bereichen künstliche Intelligenz (KI), Deep Learning und adaptive Robotik geprägt. Traditionelle Behälter-Picking-Systeme haben sich auf regelbasierte Algorithmen und klassische maschinelle Vision verlassen, die oft Schwierigkeiten mit unstrukturierten Umgebungen, Okklusionen und einer Vielzahl von Objektformen und Materialien haben. Die Integration von Deep Learning-Techniken—insbesondere von konvolutionalen neuronalen Netzwerken (CNNs) und transformerbasierten Modellen—ermöglicht es Robotern, eine überlegene Objekterkennung, Segmentierung und Pose-Schätzung zu erreichen, selbst in unordentlichen und dynamischen Umgebungen. Diese Modelle können auf großen Datensätzen trainiert werden, um sich auf unterschiedliche Szenarien zu generalisieren, was die Picking-Genauigkeit und Robustheit erheblich verbessert.

KI-gesteuerte adaptive Robotik verbessert die Flexibilität der IRB-Manipulatoren weiter, indem sie Echtzeitlernen und Anpassungen an neue Objekte oder sich ändernde Behälterbedingungen ermöglicht. Ansätze des bestärkenden Lernens und des Imitationslernens werden untersucht, um Robotern zu ermöglichen, ihre Greifstrategien durch Versuch und Irrtum oder durch Nachahmung menschlicher Demonstrationen zu optimieren. Diese Anpassungsfähigkeit ist entscheidend für Anwendungen im E-Commerce, in der Fertigung und Logistik, wo die Produktvariabilität hoch ist und Ausfallzeiten minimiert werden müssen.

Zudem erleichtert die Konvergenz von Cloud-Robotik und Edge-Computing die Einführung skalierbarer, kollaborativer Behälter-Picking-Lösungen, bei denen mehrere Roboter gelernte Modelle teilen und Aufgaben effizient koordinieren können. Wenn sich diese Technologien weiterentwickeln, können wir erwarten, dass vision-gesteuerte IRB-Manipulatoren eine nahezu menschliche Geschicklichkeit und Zuverlässigkeit erreichen, die die automatisierte Materialhandhabung transformiert. Für weitere Einblicke siehe ABB Robotics und NVIDIA Robotics.

Fazit: Die Auswirkungen und Aussichten für das visionsgesteuerte Behälter-Picking

Die Integration von vision-gesteuerten IRB-Manipulatoren im robotergestützten Behälter-Picking hat die Automatisierung komplexer, unstrukturierter Picking-Aufgaben erheblich vorangetrieben. Durch den Einsatz raffinierter 2D- und 3D-Vision-Systeme können diese Roboter Objekte genau identifizieren, lokalisieren und greifen, wodurch die traditionellen Einschränkungen in Flexibilität und Zuverlässigkeit überwunden werden. Diese Fähigkeit hat zu erheblichen Verbesserungen in Durchsatz, Qualität und Sicherheit in Branchen wie der Fertigung, Logistik und Lagerhaltung geführt. Beispielsweise haben Unternehmen wie ABB gezeigt, wie vision-gesteuerte IRB-Roboter die Zykluszeiten reduzieren und menschliches Eingreifen in sich wiederholenden oder gefährlichen Umgebungen minimieren können.

In Zukunft wird erwartet, dass die Auswirkungen des vision-gesteuerten Behälter-Pickings zunehmen, da Fortschritte in den Bereichen künstliche Intelligenz, maschinelles Lernen und Sensortechnologie weiterhin die Wahrnehmungs- und Entscheidungsfähigkeiten verbessern. Der Einsatz von Deep-Learning-Algorithmen für die Objekterkennung und Pose-Schätzung ermöglicht es Robotern bereits, eine breitere Palette von Bauteilen mit größerer Genauigkeit und Geschwindigkeit zu handhaben. Darüber hinaus steht die Integration von cloud-basierten Datenanalysen und Edge-Computing kurz davor, diese Systeme anpassungsfähiger und skalierbarer zu machen, um Echtzeit-Optimierungen und Fernüberwachung zu unterstützen (FANUC America Corporation).

Zusammenfassend lässt sich sagen, dass vision-gesteuerte IRB-Manipulatoren das Behälter-Picking von einem herausfordernden Automatisierungsproblem in eine praktikable, hochgradig wertvolle Lösung verwandeln. Wenn sich die Technologie weiterentwickelt, werden diese Systeme eine zentrale Rolle bei der Umsetzung der nächsten Welle von smarter, flexiblerer und effizienter industrieller Automatisierung spielen.