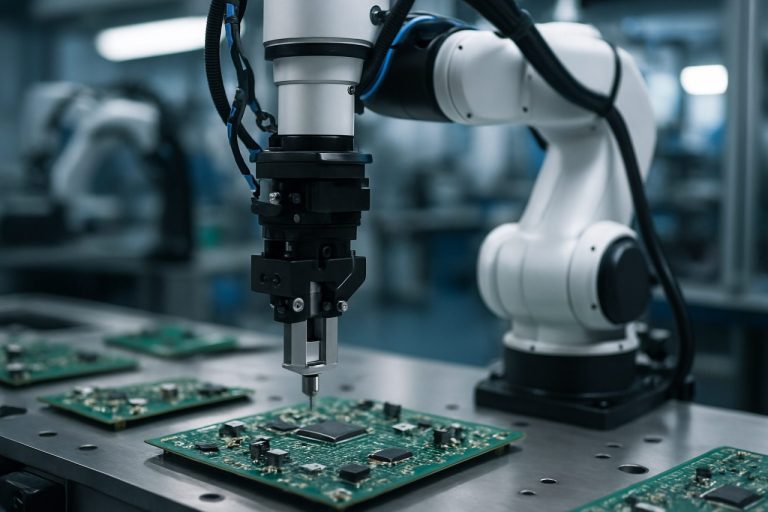

Wie vision-gesteuerte Roboter-Pick-and-Place-Systeme die Montage von mikrofluidischen Geräten transformieren—Präzision, Geschwindigkeit und Automatisierung neu definiert für die nächste Generation der Lab-on-a-Chip-Herstellung.

- Einführung in die Herausforderungen der Montage mikrofluidischer Geräte

- Prinzipien der vision-gesteuerten Roboter-Pick-and-Place-Systeme

- Schlüsseltechnologien: Kameras, Sensoren und KI-Algorithmen

- Workflow-Integration: Von der Planung zur automatisierten Montage

- Präzision und Genauigkeit: Überwindung von Mikro-Skalen-Handhabungsproblemen

- Fallstudien: Anwendungsbeispiele aus der Praxis und Leistungskennzahlen

- Vorteile gegenüber traditionellen Montagemethoden

- Einschränkungen und technische Hürden

- Zukünftige Trends: Skalierung und Anpassung in der Mikrofluidik

- Fazit: Der Weg nach vorne für die automatisierte mikrofluidische Herstellung

- Quellen & Referenzen

Einführung in die Herausforderungen der Montage mikrofluidischer Geräte

Mikrofluidische Geräte, die kleine Volumina von Flüssigkeiten innerhalb komplexer Kanalnetze manipulieren, sind zentral für Fortschritte in der biomedizinischen Diagnostik, chemischen Synthese und Lab-on-a-Chip-Technologien. Die Montage dieser Geräte stellt jedoch erhebliche Herausforderungen dar, die auf der miniaturisierten Skala, dem Bedarf an hoher Präzision und der Zerbrechlichkeit von Komponenten wie Glasplatten, Polymerlagen und Mikroventilen beruhen. Traditionelle manuelle Montagemethoden sind arbeitsintensiv, anfällig für menschliche Fehler und oft nicht wiederholbar genug für die Hochdurchsatzfertigung. Selbst geringfügige Fehlstellungen oder Kontaminationen während der Montage können die Leistung oder den Ertrag des Geräts beeinträchtigen, was die Automatisierung zu einem kritischen Ziel für das Fachgebiet macht.

Vision-gesteuerte Roboter-Pick-and-Place-Systeme bieten eine vielversprechende Lösung für diese Herausforderungen, indem sie fortschrittliche Bildverarbeitung und robotergestützte Manipulation integrieren. Diese Systeme nutzen hochauflösende Kameras und ausgeklügelte Bildverarbeitungsalgorithmen, um mikrofluidische Komponenten mit mikrometergenauer Präzision zu erkennen, zu lokalisieren und auszurichten. Der Roboter kann dann präzise Pick-and-Place-Vorgänge ausführen, wodurch das Risiko von Schäden verringert und eine konsistente Ausrichtung sichergestellt wird. Trotz dieser Vorteile bleiben mehrere Hindernisse bestehen, darunter die zuverlässige Erkennung transparenter oder halbtransparenter Teile, die Kompensation für Komponentenvariabilität und die Integration von Echtzeit-Feedback, um sich an dynamische Montagebedingungen anzupassen. Diese Probleme anzugehen, ist entscheidend, um eine skalierbare, kosteneffektive und ertragreiche Produktion mikrofluidischer Geräte zu erreichen.

Jüngste Forschungs- und Industrieanstrengungen, wie die des National Institute of Standards and Technology und der Fraunhofer-Gesellschaft, entwickeln aktiv vision-gesteuerte robotische Lösungen, die auf die einzigartigen Anforderungen der Montage mikrofluidischer Geräte zugeschnitten sind. Diese Initiativen unterstreichen die Bedeutung interdisziplinärer Zusammenarbeit zwischen Robotik, Computer Vision und Mikrofabrikation, um aktuelle Einschränkungen zu überwinden und die nächste Generation mikrofluidischer Technologien zu ermöglichen.

Prinzipien der vision-gesteuerten Roboter-Pick-and-Place-Systeme

Vision-gesteuerte Roboter-Pick-and-Place-Systeme integrieren fortschrittliche Computer Vision-Algorithmen mit robotischen Manipulatoren, um präzise, automatisierte Handhabung von Komponenten zu ermöglichen. Im Kontext der Montage mikrofluidischer Geräte sind diese Systeme aufgrund der kleinen Größe, Zerbrechlichkeit und engen Toleranzen von mikrofluidischen Teilen unerlässlich. Das Kernprinzip besteht darin, Kameras oder andere Bildsensoren zu verwenden, um Echtzeit-Bilddaten des Arbeitsbereichs zu erfassen. Diese Daten werden verarbeitet, um die Position, Ausrichtung und manchmal die Qualität mikrofluidischer Komponenten zu identifizieren, sodass der Roboter seine Bewegungen dynamisch für genaue Pick-and-Place-Vorgänge anpassen kann.

Ein typisches vision-gesteuertes System besteht aus mehreren Schlüsselmodulen: Bildaufnahme, Bildverarbeitung, Objekterkennung, Bewegungsplanung und Feedbacksteuerung. Hochauflösende Kameras oder Mikroskope erfassen Bilder, die dann mit Bildverarbeitungstechniken wie Kantenerkennung, Vorlagenabgleich oder maschinellem Lernen zur Objekterkennung analysiert werden. Das System berechnet die genauen Koordinaten und die Ausrichtung jeder Komponente, die in Roboterbewegungsbefehle übersetzt werden. Geschlossene Regelkreise stellen sicher, dass der Roboter in Echtzeit für etwaige Fehlstellungen oder Positionsfehler kompensiert, was die Montagegenauigkeit und den Ertrag erheblich verbessert.

Für die Montage mikrofluidischer Geräte ist die vision-gesteuerte Unterstützung besonders wertvoll für Aufgaben wie das Ausrichten von Mikrokanälen, das Platzieren von Membranen oder das Verkleben von Schichten, bei denen submillimetergenauigkeit erforderlich ist. Die Integration von Visionssystemen ermöglicht auch die Qualitätsinspektion während der Montage, wodurch Defekte reduziert und der Durchsatz erhöht wird. Jüngste Fortschritte im Bereich des Deep Learning und der 3D-Vison haben die Robustheit und Flexibilität dieser Systeme weiter verbessert, wodurch sie in modernen Mikrofabrikationsumgebungen unverzichtbar werden National Institute of Standards and Technology, IEEE.

Schlüsseltechnologien: Kameras, Sensoren und KI-Algorithmen

Die Effektivität vision-gesteuerter Roboter-Pick-and-Place-Systeme in der Montage mikrofluidischer Geräte beruht auf der Integration fortschrittlicher Kameras, präziser Sensoren und ausgeklügelter KI-Algorithmen. Hochauflösende Industriekameras, wie solche, die CMOS- oder CCD-Technologie verwenden, sind unerlässlich, um detaillierte Bilder von mikro-skalierten Komponenten zu erfassen, was eine genaue Lokalisierung und Ausrichtungsdetektion ermöglicht. Diese Kameras werden häufig mit telezentrischen Objektiven kombiniert, um Verzerrungen zu minimieren und eine konsistente Messung im gesamten Sichtfeld sicherzustellen, was für die Handhabung der submillimetergenauen Merkmale typischer mikrofluidischer Geräte entscheidend ist (Basler AG).

Ergänzend zu den visuellen Daten bieten Kraft- und Tastsensoren Echtzeit-Feedback zur Interaktion zwischen dem robotischen Endeffektor und empfindlichen mikrofluidischen Teilen. Dieses Feedback ist entscheidend, um Schäden während des Greifens und Platzierens zu vermeiden, insbesondere beim Umgang mit zerbrechlichen Materialien wie PDMS oder Glas. Fortschrittliche Näherungs- und Laserverschiebungssensoren verbessern die Positionsgenauigkeit weiter und ermöglichen eine geschlossene Regelung während der Montage (ATI Industrial Automation).

KI-Algorithmen, insbesondere solche, die auf Deep Learning und Computer Vision basieren, spielen eine entscheidende Rolle bei der Interpretation von Sensordaten und der Steuerung robotischer Aktionen. Faltungsneuronale Netzwerke (CNNs) werden häufig für die Objekterkennung, Segmentierung und Pose-Schätzung verwendet, wodurch das System sich an Variationen in der Geometrie und Ausrichtung der Teile anpassen kann. Verstärkendes Lernen und adaptive Steuerungsalgorithmen optimieren den Pick-and-Place-Prozess weiter, indem sie die Leistung basierend auf Feedback aus vorherigen Montagezyklen kontinuierlich verbessern (NVIDIA). Die Synergie dieser Technologien gewährleistet hohe Präzision, Wiederholbarkeit und Skalierbarkeit in der Montage mikrofluidischer Geräte.

Workflow-Integration: Von der Planung zur automatisierten Montage

Die Integration vision-gesteuerter Roboter-Pick-and-Place-Systeme in den Workflow der Montage mikrofluidischer Geräte erfordert einen nahtlosen Übergang von digitalem Design zur automatisierten physischen Realisierung. Der Prozess beginnt typischerweise mit computergestützten Entwurfsmodellen (CAD) von mikrofluidischen Komponenten, die in präzise Montageanweisungen übersetzt werden. Diese digitalen Blaupausen werden dann mit der Robotersteuerungssoftware verbunden, die es dem Roboter ermöglicht, die Geometrien der Komponenten, räumlichen Beziehungen und Montagefolgen zu interpretieren. Visionssysteme, die oft auf hochauflösenden Kameras und fortschrittlichen Bildverarbeitungsalgorithmen basieren, spielen eine entscheidende Rolle in diesem Workflow, indem sie Echtzeit-Feedback zu den Positionen und Ausrichtungen der Komponenten bereitstellen und dabei Fertigungstoleranzen und Platzierungsfehler kompensieren.

Ein zentraler Aspekt der Workflow-Integration ist die Synchronisation zwischen dem Visionssystem und dem robotischen Manipulator. Das Visionssystem erkennt fiduzielle Marker oder einzigartige Merkmale an mikrofluidischen Teilen, wodurch der Roboter seine Trajektorie dynamisch anpassen kann, um genaue Pick-and-Place-Vorgänge durchzuführen. Dieses geschlossene Feedback sorgt für hohe Präzision, die angesichts der mikroskaligen Toleranzen, die in der Montage mikrofluidischer Geräte erforderlich sind, unerlässlich ist. Darüber hinaus müssen Softwareplattformen die Interoperabilität zwischen Entwurfsdateien, Ausgaben der Bildverarbeitung und Robotersteuerungsbefehlen unterstützen, wobei häufig standardisierte Kommunikationsprotokolle und modulare Architekturen verwendet werden (National Institute of Standards and Technology).

Eine erfolgreiche Integration umfasst auch die Validierung des Workflows, bei der die montierten Geräte inspiziert werden—manchmal unter Verwendung desselben Visionssystems—um die Ausrichtung und die Qualität der Verklebung zu überprüfen. Diese End-to-End-Automatisierung beschleunigt nicht nur die Prototypenentwicklung und Produktion, sondern verbessert auch die Reproduzierbarkeit und Skalierbarkeit in der Herstellung mikrofluidischer Geräte (Festo). Daher wird die vision-gesteuerte Robotermontage zu einer Schlüsseltechnologie für die Fertigungsworkflows der nächsten Generation in der Mikrofluidik.

Präzision und Genauigkeit: Überwindung von Mikro-Skalen-Handhabungsproblemen

Hohe Präzision und Genauigkeit in vision-gesteuerten Roboter-Pick-and-Place-Vorgängen zu erreichen, ist insbesondere auf mikroskaliger Ebene herausfordernd, wie es für die Montage mikrofluidischer Geräte erforderlich ist. Die geringe Größe mikrofluidischer Komponenten—die oft von mehreren Zehnteln bis zu mehreren Hundert Mikrometern reicht—erfordert submikrometer genaue Positionierungsgenauigkeit und Wiederholbarkeit. Traditionelle robotische Systeme, die für makroskalige Aufgaben konzipiert sind, haben Schwierigkeiten mit den feinen Toleranzen und der empfindlichen Handhabung, die in dieser Skala erforderlich sind. Zu den wichtigsten Hindernissen gehören die Einschränkungen des Designs des Endeffektors, die Auswirkungen von statischer Elektrizität und van der Waals-Kräften sowie die Schwierigkeit, Echtzeit-Visuelles Feedback bei hohen Auflösungen zu erhalten.

Um diese Herausforderungen zu überwinden, werden fortschrittliche Visionssysteme mit hochvergrößernden Kameras und ausgeklügelten Bildverarbeitungsalgorithmen integriert, die die Erkennung und Lokalisierung von mikro-skalierten Merkmalen mit hoher Genauigkeit ermöglichen. Echtzeit-Feedback-Schleifen ermöglichen eine dynamische Korrektur von Positionierungsfehlern und kompensieren mechanisches Spiel und thermische Drift. Darüber hinaus werden spezialisierte Mikrogreifer—wie solche, die Vakuum-, elektrostatistische oder kapillare Kräfte nutzen—eingesetzt, um mechanischen Stress zu minimieren und Schäden an Komponenten während der Manipulation zu verhindern. Kalibrierungsroutinen und maschinenlernbasierte Fehlerkompensation verbessern zusätzlich die Fähigkeit des Systems, sich an Komponentenvariabilität und Umgebungsfluktuationen anzupassen.

Jüngste Forschungen zeigen, dass die Kombination dieser Technologien Platzierungsgenauigkeiten innerhalb weniger Mikrometer erreichen kann, was den Montageertrag und die Geräteleistung erheblich verbessert. Beispielsweise haben gemeinsame Bemühungen des National Institute of Standards and Technology (NIST) und des Massachusetts Institute of Technology (MIT) zur Entwicklung robotischer Plattformen geführt, die eine zuverlässige mikrofluidische Montage ermöglichen und den Weg für die skalierbare und automatisierte Produktion komplexer Lab-on-a-Chip-Geräte ebnen.

Fallstudien: Anwendungsbeispiele aus der Praxis und Leistungskennzahlen

Jüngste Fortschritte bei vision-gesteuerten Roboter-Pick-and-Place-Systemen haben bedeutende Fortschritte in der automatisierten Montage von mikrofluidischen Geräten ermöglicht, die hohe Präzision und Wiederholbarkeit erfordern. Fallstudien führender Forschungseinrichtungen und der Industrie zeigen die praktische Anwendung dieser Systeme in realen Fertigungsumgebungen. So hat das National Institute of Standards and Technology (NIST) berichtet, dass vision-gesteuerte Roboter zur Ausrichtung und Montage mikrofluidischer Chips mit sub-10-Mikron-Genauigkeit eingesetzt werden, was menschliche Fehler erheblich reduziert und den Durchsatz erhöht. Ebenso hat die Fraunhofer-Gesellschaft Maschinenvisionsalgorithmen für die Echtzeit-Qualitätsinspektion während des Pick-and-Place-Prozesses implementiert, um eine fehlerfreie Montage und Rückverfolgbarkeit zu gewährleisten.

Leistungskennzahlen, die in diesen Fallstudien häufig bewertet werden, umfassen Platzierungsgenauigkeit, Zykluszeit, Ertragsquote und Systemanpassungsfähigkeit. Beispielsweise hat eine Studie des Massachusetts Institute of Technology (MIT) gezeigt, dass die Integration von Deep Learning-basierten Visionssystemen mit Roboterarmen die Montagezeit um 30 % reduzierte, während eine Platzierungsgenauigkeit von ±5 Mikrometern beibehalten wurde. Ertragsquoten von über 98 % wurden berichtet, wenn geschlossene Regelkreise von Visionssystemen verwendet wurden, um Fehlstellungen in Echtzeit zu korrigieren. Darüber hinaus wurde die Anpassungsfähigkeit an unterschiedliche Designs mikrofluidischer Geräte durch modulare Greiferdesigns und flexible Visionsalgorithmen erreicht, wie von IMTEK – Universität Freiburg hervorgehoben.

Diese Fallstudien unterstreichen die transformative Wirkung der vision-gesteuerten Robotik auf die Montage mikrofluidischer Geräte und bieten skalierbare Lösungen, die den strengen Anforderungen der biomedizinischen und analytischen Geräteherstellung gerecht werden.

Vorteile gegenüber traditionellen Montagemethoden

Vision-gesteuerte Roboter-Pick-and-Place-Systeme bieten erhebliche Vorteile gegenüber traditionellen manuellen oder halbautomatisierten Montagemethoden im Kontext der Herstellung mikrofluidischer Geräte. Einer der Hauptvorteile ist die erhebliche Verbesserung der Präzision und Wiederholbarkeit. Visionssysteme ermöglichen es Robotern, winzige Positionsfehler zu erkennen und zu korrigieren, wodurch eine genaue Ausrichtung und Platzierung mikro-skalierten Komponenten sichergestellt wird, was für die Funktionalität mikrofluidischer Geräte entscheidend ist National Institute of Standards and Technology. Dieses Maß an Genauigkeit ist mit menschlichen Bedienern, insbesondere angesichts der geringen Größe und der empfindlichen Natur mikrofluidischer Teile, schwer konstant zu erreichen.

Ein weiterer wichtiger Vorteil ist die Steigerung des Durchsatzes und der Skalierbarkeit. Automatisierte vision-gesteuerte Systeme können kontinuierlich und schneller als die manuelle Montage arbeiten, was die Produktionsraten erheblich erhöht und die Arbeitskosten senkt International Federation of Robotics. Dies ist besonders wichtig, da die Nachfrage nach mikrofluidischen Geräten in Bereichen wie Diagnostik, Arzneimittelentwicklung und Umweltüberwachung steigt.

Darüber hinaus verbessern vision-gesteuerte Robotik die Qualitätskontrolle, indem sie Echtzeitinspektionen und Feedback während des Montageprozesses ermöglichen. Defekte oder fehlplatzierte Komponenten können sofort erkannt und korrigiert werden, was Abfall reduziert und höhere Erträge sichert International Organization for Standardization. Die Automatisierung der Datenerfassung erleichtert auch die Rückverfolgbarkeit und Prozessoptimierung und unterstützt die Einhaltung strenger Branchenstandards.

Zusammenfassend bieten vision-gesteuerte Roboter-Pick-and-Place-Systeme überlegene Präzision, Effizienz und Qualitätssicherung im Vergleich zu traditionellen Montagemethoden, was sie für die komplexen und anspruchsvollen Anforderungen der Montage mikrofluidischer Geräte äußerst vorteilhaft macht.

Einschränkungen und technische Hürden

Trotz erheblicher Fortschritte stehen vision-gesteuerte Roboter-Pick-and-Place-Systeme für die Montage mikrofluidischer Geräte vor mehreren Einschränkungen und technischen Hürden. Eine der größten Herausforderungen ist die präzise Handhabung mikro-skalierten Komponenten, die oft Abmessungen im Bereich von mehreren Zehnteln bis Hunderten von Mikrometern aufweisen. Die Erreichung submikrometer genauer Positionierung und Ausrichtung ist aufgrund der Einschränkungen sowohl der Auflösung des Visionssystems als auch der Wiederholbarkeit der robotischen Aktoren schwierig. Variationen in der Beleuchtung, Reflexionen von transparenten oder halbtransparenten mikrofluidischen Materialien und die Präsenz von Staub oder Schmutz können die Bildqualität weiter beeinträchtigen und die zuverlässige Merkmalsdetektion und -lokalisierung erschweren (Nature Publishing Group).

Eine weitere bedeutende Hürde ist die Integration von Echtzeit-Feedback und adaptiver Steuerung. Mikrofluidische Komponenten sind oft empfindlich und anfällig für Schäden durch übermäßige Kraft oder Fehlstellungen. Die Entwicklung robuster Kraftsensoren und nachgiebiger Manipulationsstrategien bleibt ein fortlaufendes Forschungsgebiet. Darüber hinaus kann der Montageprozess die Handhabung unterschiedlicher Materialien erfordern—wie PDMS, Glas oder Thermoplasten—die jeweils einzigartige optische und mechanische Eigenschaften aufweisen, was anpassungsfähige Visionsalgorithmen und Designs für Endeffektoren erfordert (IEEE).

Skalierbarkeit und Durchsatz stellen ebenfalls Herausforderungen dar. Während vision-gesteuerte Systeme repetitive Aufgaben automatisieren können, kann die Geschwindigkeit der Bildverarbeitung und Bewegungsplanung die Gesamtmontageraten begrenzen, insbesondere wenn hohe Präzision erforderlich ist. Darüber hinaus erschwert das Fehlen standardisierter Schnittstellen und Protokolle für Komponenten mikrofluidischer Geräte die Entwicklung universell anwendbarer robotischer Lösungen (Elsevier). Die Bewältigung dieser Einschränkungen ist entscheidend für die weitverbreitete Einführung automatisierter mikrofluidischer Geräte-Montage in Forschung und Industrie.

Zukünftige Trends: Skalierung und Anpassung in der Mikrofluidik

Die Zukunft der vision-gesteuerten Roboter-Pick-and-Place-Systeme in der Montage mikrofluidischer Geräte steht vor bedeutenden Fortschritten, insbesondere in den Bereichen Produktionsskalierung und Ermöglichung größerer Anpassungen. Da mikrofluidische Geräte zunehmend komplexer und anwendungsspezifischer werden, wächst die Nachfrage nach flexiblen, hochdurchsatzfähigen Montage-Lösungen. Vision-gesteuerte Robotik, die fortschrittliche Maschinenvision und KI-gesteuerte Entscheidungsfindung nutzt, wird voraussichtlich eine entscheidende Rolle bei der Erfüllung dieser Anforderungen spielen, indem sie eine schnelle Anpassung an neue Gerätedesigns und -layouts ohne umfangreiche Neuprogrammierung oder Werkzeugänderungen ermöglicht.

Ein wichtiger Trend ist die Integration von maschinellen Lernalgorithmen mit Visionssystemen, die es Robotern ermöglichen, eine größere Vielfalt mikrofluidischer Komponenten mit minimalem menschlichem Eingreifen zu erkennen und zu manipulieren. Diese Anpassungsfähigkeit ist entscheidend sowohl für die Massenproduktion als auch für die Herstellung maßgeschneiderter Geräte, die auf spezifische Forschungs- oder klinische Bedürfnisse zugeschnitten sind. Darüber hinaus verbessern Fortschritte in der Kamerahochauflösung und der Echtzeit-Bildverarbeitung die Präzision und Zuverlässigkeit von Pick-and-Place-Vorgängen, selbst wenn die Merkmale der Geräte auf die submillimetergroße Skala schrumpfen.

Die Skalierbarkeit wird zudem durch die Entwicklung modularer robotischer Arbeitszellen unterstützt, die leicht umkonfiguriert oder erweitert werden können, um erhöhte Produktionsvolumina oder neue Gerätetypen aufzunehmen. Eine solche Modularität, kombiniert mit cloudbasiertem Datenaustausch und Prozessüberwachung, ermöglicht es Herstellern, die Betriebe schnell zu skalieren und gleichzeitig strenge Qualitätskontrollstandards aufrechtzuerhalten. Wenn sich diese Technologien weiterentwickeln, wird die vision-gesteuerte Robotermontage voraussichtlich zu einem Grundpfeiler sowohl der großangelegten als auch der hochgradig angepassten Herstellung mikrofluidischer Geräte werden, um Innovationen in der Diagnostik, Arzneimittelentwicklung und darüber hinaus zu unterstützen (Nature Reviews Materials; National Institute of Standards and Technology).

Fazit: Der Weg nach vorne für die automatisierte mikrofluidische Herstellung

Die Integration vision-gesteuerter Roboter-Pick-and-Place-Systeme in die Montage mikrofluidischer Geräte stellt einen transformativen Schritt in Richtung skalierbarer, hochpräziser Fertigung dar. Da mikrofluidische Geräte zunehmend komplexer und miniaturisierter werden, haben traditionelle manuelle Montagemethoden Schwierigkeiten, die Anforderungen an Genauigkeit, Wiederholbarkeit und Durchsatz zu erfüllen. Vision-gesteuerte Robotik, die fortschrittliche Bildverarbeitung und maschinelles Lernen nutzt, bietet eine robuste Lösung, indem sie die Echtzeiterkennung von Teilen, Ausrichtung und Qualitätssicherung während der Montageprozesse ermöglicht. Dies reduziert nicht nur menschliche Fehler, sondern beschleunigt auch die Produktionszyklen und erleichtert die schnelle Prototypenentwicklung neuartiger Gerätearchitekturen.

Wenn wir in die Zukunft blicken, wird der Weg zur vollautomatisierten mikrofluidischen Herstellung durch mehrere wichtige Fortschritte geprägt sein. Fortlaufende Verbesserungen in der Computer Vision—wie hochauflösende Bildgebung, 3D-Rekonstruktion und adaptive Beleuchtung—werden die Präzision und Zuverlässigkeit robotischer Systeme weiter verbessern. Die Integration mit künstlicher Intelligenz wird prädiktive Wartung, adaptive Prozessoptimierung und autonome Fehlerkorrektur ermöglichen und die Grenzen dessen, was in der Mikroskaligen Montage möglich ist, erweitern. Darüber hinaus wird die Entwicklung standardisierter Schnittstellen und modularer robotischer Plattformen die Interoperabilität und Flexibilität fördern, sodass Hersteller schnell auf neue Gerätedesigns und Produktionsanforderungen reagieren können.

Die Zusammenarbeit zwischen Wissenschaft, Industrie und Normungsorganisationen wird entscheidend sein, um Herausforderungen im Zusammenhang mit Systemintegration, Validierung und regulatorischer Konformität zu bewältigen. Wenn sich diese Technologien weiterentwickeln, steht die vision-gesteuerte Robotermontage bereit, das Rückgrat der nächsten Generation mikrofluidischer Fertigung zu werden und kosteneffektive, hochdurchsatzfähige Produktion für Anwendungen von der biomedizinischen Diagnostik bis zur chemischen Synthese zu ermöglichen. Die fortlaufende Evolution dieses Bereichs verspricht neue Möglichkeiten sowohl in der Forschung als auch im kommerziellen Bereich, wie die Initiativen von Organisationen wie dem National Institute of Standards and Technology und dem Institute of Electrical and Electronics Engineers zeigen.

Quellen & Referenzen

- National Institute of Standards and Technology

- Fraunhofer Society

- IEEE

- ATI Industrial Automation

- NVIDIA

- Massachusetts Institute of Technology (MIT)

- IMTEK – Universität Freiburg

- International Federation of Robotics

- International Organization for Standardization

- Nature Publishing Group